Las últimas generaciones de aceleradores de partículas son dispositivos que impresionan por su tamaño y por la tecnología desarrollada para hacerlos funcionar. Son instrumentos muy poderosos que han sido diseñados para forzar a circular, a altísimas velocidades (altísimas energías) y en sentido opuesto, dos haces de: protones, electrones, positrones, núcleos atómicos, etc., con el fin de hacerlos colisionar en un punto determinado de un espacio confinado, donde se monitorizan las trayectorias de los restos generados al destrozar sus estructuras internas. Este procedimiento ha demostrado ser muy exitoso a la hora de adquirir conocimientos, de forma experimental, sobre las entidades del nivel subatómico; lo que justifica sobradamente las enormes cantidades de dinero, recursos e ingenio invertidos. Gracias a ellos se ha podido deducir que esos restos de las colisiones, que se proyectan en todas direcciones (a veces en forma de chorros o jets), están constituidos por grandes cantidades de mesones (parejas de quarks). De ahí que actualmente se acepte la idea de que los quarks más livianos son los constituyentes básicos de toda la materia. Podríamos decir que son los ladrillos necesarios para toda construcción material y que los gluones (los bosones transmisores de la fuerza fuerte) serían el cemento que los mantiene unidos.

Aquellos que confían en el alto grado de solidez de la mecánica cuántica y del modelo estándar, bases del paradigma actual de la física en el nivel subatómico, dirán que, al redactar el párrafo anterior, he cometido al menos un error. Amparados en las hipótesis surgidas de la famosa fórmula de Albert Einstein (E = m·c²), dirán que los mesones observados no son los restos de las estructuras preexistentes de las partículas, sino que han sido creados partiendo de la alta energía adquirida por los quarks que, al dispersarse durante las colisiones, se transforma en nuevas entidades materiales. Esta forma de entender las interacciones en lo más pequeño, también tiene mucho que ver con el convencimiento, casi unánime, de que la dualidad onda-corpúsculo define la forma de proceder de las entidades fundamentales en estas escalas. Y es en este punto donde me paro a pensar… Esto podía tener sentido mientras hemos creído que todas las partículas eran elementales, es decir, sin partes más pequeñas; así la materia y la energía permutarían la una en la otra, sin mayor conflicto lógico. Sin embargo, cuando deducimos que los bariones (protones y neutrones) son entes compuestos, no me es posible imaginar cómo podemos seguir creyendo que se pueden crear estas estructuras, más o menos complejas, de forma instantánea (sin mediar una evolución previa). Además, está el asunto del momento magnético típico de cada partícula. Una evidencia que debería haber sido más que suficiente para especular con la idea de que muchas de las que todavía consideramos elementales -al igual que las ya descritas como compuestas, pero únicamente por tres quarks- en realidad son estructuras tridimensionales en rotación, formadas por agrupaciones ordenadas de numerosas partículas más pequeñas que poseen carga eléctrica. Lo que explicaría su momento magnético, no como algo «intrínseco» de cada una ─eufemismo utilizado para ocultar la ausencia de una hipótesis coherente sobre su origen─, sino como algo común en física clásica; algo que podemos observar en todos los niveles de la naturaleza.

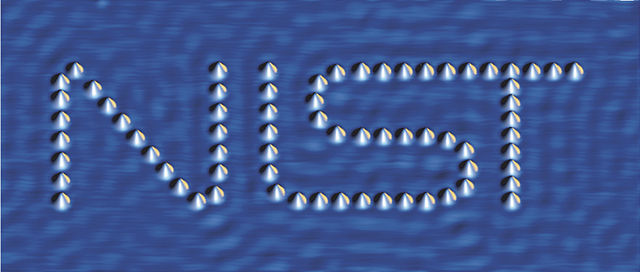

El objetivo de esta «teoría de ruedas» es mostrar cómo, partiendo de los mesones y de manera causal, se puede llegar a un autentico modelo físico que nos sirva para explicar la formación de los átomos y las cualidades de sus componentes. Para ello expondré hipótesis que siguen la estrategia heurística inversa a la de los aceleradores de partículas, es decir, imaginaremos cómo evolucionan esos entes materiales, en un constructo teórico, para formar nuevas estructuras dentro de un entorno natural coherente, que no cambia sus reglas al cambiar la escala observada. Donde únicamente la intensidad de las fuerzas implicadas en las interacciones marcan la diferencia entre lo más grande y lo más pequeño. Consideraremos que la realidad material o corpuscular no es algo eventual, pues ya es posible observar y manipular átomos individualmente y existen dispositivos que funcionan electrón a electrón (como los «sensores de puerta» desarrollados en la Universidad de Cambridge); lo que demuestra, sin duda, que estas entidades tienen una existencia física material concreta y duradera.

Por tanto, superaremos la concepción probabilística del nivel subatómico, regida por el principio de incertidumbre (la relación de indeterminación de Heisenberg) a la que, ya en su momento, se opusieron varios de los físicos más prestigiosos, entre los que se encontraba algunos de los que habían contribuido notablemente a la creación de la mecánica cuántica, como son: Born, Planck, Schrödinger, Sommerfeld, etc. También Einstein, que en su artículo de mayo de 1940 para Science, titulado «Los fundamentos de la física teórica» dijo:

«Algunos físicos, entre los que me incluyo, no pueden creer que debamos abandonar, realmente y para siempre, la idea de la representación directa de la realidad física en el espacio y el tiempo; o que debamos aceptar la idea de que los sucesos en la naturaleza son análogos a un juego de azar. Está abierto a cada hombre el elegir la dirección de su esfuerzo; y también cada hombre puede hallar consuelo en el lema de Lessing: la búsqueda de la verdad es más preciosa que su posesión».

Si algo tengo claro es que, en la naturaleza, la sencillez es un valor muy importante y en la inmensa pequeñez del «mundo subatómico» tiene que serlo en extremo. Por tanto, deberíamos aplicar el principio de simplicidad para elegir la solución más correcta ante una disyuntiva que se nos presente al intentar resolver algún problema en este nivel. Sin embargo, la teoría cuántica, con la que actualmente se intenta dar explicación a las interacciones subatómicas y a los fenómenos derivados de estas, es todo menos simple. Son sumamente desconcertantes muchas de las conclusiones a las que han llegado durante su desarrollo y el propio Niels Bohr, otro de los padres de esta teoría, lo aseveró diciendo la famosa frase:

«Cuando alguien afirma que puede plantearse problemas cuánticos sin sentirse mareado, simplemente demuestra que no ha entendido absolutamente nada de ellos».

Él mismo también dijo, el 29 de agosto de 1930, en una carta dirigida a Paul Dirac:

«Creo firmemente, que la solución de los problemas actuales no se alcanzará sin una revisión de nuestras ideas físicas generales aún más profunda de la que se contempla en la mecánica cuántica actual».*

(*) Cita extraída de la obra de José Manuel Sánchez Ron: «El mundo después de la revolución».

Por supuesto, las teorías no cesan de revisarse y ampliarse, pero resulta asombroso descubrir que si releemos la última cita, pensando en la situación actual, ésta sigue teniendo plena vigencia; o eso me parece a mí. Porque hay que tener en cuenta que, durante el siglo XX y lo que llevamos del XXI, la humanidad está siendo testigo de una revolución científica y tecnológica de tal magnitud, con resultados tan sorprendentes y desarrollada a tal ritmo; que las ideas han adquirido su propia inercia y, para seguir avanzando, estamos obviando los “cabos sueltos” que a menudo detectamos; aunque estos evidencien que ha de haber algo fundamental que no ha sido bien entendido y que, en contraposición a ese futuro avance de la ciencia, puede servir de germen para la especulación sobre algunos supuestos inverosímiles que están instalándose en la conciencia colectiva. De ahí que sean numerosas las personas que, incluso desde el seno de la comunidad científica, nos estén alertado de que no todo está tan bien atado como creemos y que debe haber «nueva física» tras el modelo estándar. Pero hemos colocado a las teorías científicas vigentes en un inmenso pedestal, cimentado con los abrumadores éxitos obtenidos, y esto dificulta sobremanera el que nuevas ideas coherentes, que se caractericen por ser simples y válidas en todos los niveles de la naturaleza, puedan debatirse hasta desarrollar otras teorías que pongan al descubierto alguno de esos conceptos erróneos o incompletos de la física actual.

Uno de esos “cabos sueltos” es la masa de los constituyentes del núcleo atómico: el protón y el neutrón. Cada uno está formado, supuestamente, por tres quarks de la primera generación del modelo estándar, cuya masa sumada es sólo una mínima porción de la medida experimentalmente para cada uno de ellos. Esto resulta del todo inaceptable, por lo que se intenta justificar diciendo que la energía de la fuerza fuerte, encargada de mantener unidos sus quarks, es equivalente a la masa que falta. Sin embargo, la masa de esos quarks se ha calculado partiendo de mesones; porque un quark no puede encontrarse aislado, al menos deben formar parejas unidas por esa misma fuerza; y, si la energía de la fuerza fuerte no se ha manifestado como masa en las mediciones referidas al mesón… ¿por qué habría de medirse como masa de los nucleones? Ahora bien, si estamos dispuestos a considerar la posibilidad de que el protón y el neutrón puedan estar constituidos por esas estructuras ordenadas en tres dimensiones a las que me referí al hablar sobre el momento magnético, deberíamos considerar también que la manera más sencilla de evolucionar hacia una construcción sólida es adicionando subestructuras con formaciones triangulares. En este nivel, cada una de esas subestructuras se obtendría como resultado de la unión de varios mesones que reagruparían sus quarks en múltiplos de tres. De esta manera, no habría problema para que la suma de las masas individuales, de todos los quarks implicados, dé la medida real del nucleón. La cuestión quedaría resuelta como un simple error de identificación de la escala idónea para poner en relación los distintos entes subatómicos.

A priori, esta forma de proceder no supondría dar la espalda a la física actual, porque esas estructuras deberán evolucionar de forma lógica para adquirir todas las cualidades necesarias para ser congruentes con las observaciones realizadas y, en general, con lo teorizado por la electrodinámica y la cromodinámica cuánticas. Para lo cual deben permanecer “de color blanco” -este concepto no tiene nada que ver con la noción de color en el nivel macro, sino con el confinamiento de los hadrones (formaciones de varios quarks, unidos por la fuerza fuerte)- y también deben poseer determinado momento magnético, carga eléctrica, etc. Atributos que darán lugar a la diferenciación de las entidades subatómicas y que les permitirán recorrer los siguientes pasos de la evolución de la materia hacia la formación de los primeros átomos ligeros. De la unión de sus núcleos surgirán los elementos más pesados y, con todos ellos, las distintas moléculas inorgánicas y orgánicas. Pero, como todos son constituyentes de los seres vivos y solo hemos adquirido “conciencia” al final de esta cadena de sucesos, debemos desechar aquellas interpretaciones de la teoría cuántica que, asignando un papel relevante al observador en el devenir de los acontecimientos, tratan de justificar con argumentos metafísicos lo que no alcanzan a comprender por medio del método científico.

Con este trabajo trato únicamente de remozar el debate, para que se siga avanzando en el conocimiento de lo que nos rodea y de lo que estamos hechos, porque la ciencia todavía está lejos de saberlo todo sobre los mecanismos naturales. Sin embargo, soy consciente de que la comunidad científica, en general, no dará crédito y se mostrará indiferente; lo que, ciertamente, resulta frustrante. A este respecto recurro de nuevo a Albert Einstein, porque me parece interesante recordar lo que escribió en su libro “Notas autobiográficas» sobre algunos científicos de su época:

«La aversión de estos investigadores hacia la teoría atómica hay que atribuirla sin duda a su actitud filosófica positivista, lo cual constituye un interesante ejemplo de que incluso investigadores de espíritu audaz y fino instinto pueden verse estorbados por prejuicios filosóficos a la hora de interpretar los hechos. El prejuicio –que desde entonces no se ha extinguido─ consiste en creer que los hechos por sí solos, sin libre construcción conceptual, pueden y deben proporcionar conocimiento científico. Semejante ilusión solamente se explica porque no es fácil percatarse de que aquellos conceptos que, por estar contrastados y llevar largo tiempo en uso, parecen conectados directamente con el material empírico, están en realidad libremente elegidos».

En mi opinión, ese prejuicio todavía hoy sigue existiendo. Pero, a pesar de todo, mantengo la confianza y espero que no sea necesario aguardar a que una nueva generación de físicos consideren estudiar esta teoría, cuando el recorrido del actual modelo estándar alcance su inevitable, y cada vez más próximo, final. Porque la vía de la divulgación científica, que gracias a Internet ha alcanzado cotas inimaginables, ha de aprovecharse dejando que las ideas fluyan y se engrandezcan en las dos direcciones. Aunque, por supuesto, la aceptación de una nueva teoría física deba pasar siempre por la obtención de un mínimo consenso entre científicos, en la historia de la ciencia son numerosos los ejemplos de aficionados autodidactas, cuya aportación ha servido para que podamos seguir avanzando en el entendimiento de la naturaleza. La Web está haciendo posible que el número de pensadores (profesionales y amateurs) sea ahora mucho mayor que nunca. Desaprovechar esta fuente de inspiración, como un recurso válido, no hace más que alejar en el tiempo el conocimiento de la realidad física. Por eso, el lector que se arme del natural escepticismo, pero mantenga la curiosidad por conocer los argumentos que expongo en este documento, descubrirá que, a pesar de su sencillez o más bien gracias a ella, se pueden explicar fácilmente cuestiones como: el porqué del continuo cambio en el espín del electrón, qué es la interacción débil, cómo es el núcleo del átomo de cualquier elemento de la tabla periódica, qué mantiene unidos a los nucleones, porqué se produce la superfluidez del Helio y del Litio, qué es el condensado Bose-Einstein, etc. Así mismo, podremos entender mejor: la radioactividad, el efecto fotoeléctrico, el efecto Compton, el efecto Stark, el efecto Zeeman, el efecto túnel, el efecto Josephson, la fotodesintegración, la creación de pares electrón-positrón, etc. Además, especulo sobre: el origen de la gravedad, la masa, la energía oscura, la antimateria, la materia oscura, etc. También propongo aquí una nueva clasificación de entidades subatómicas, basada en el tipo de agrupaciones teóricas que se pueden dar entre las distintas estructuras que se forman. Y, al final, visualizaremos un nuevo modelo atómico, que permite entender mejor los enlaces moleculares y que también sirve para describir el principio físico que mueve las aspas del radiómetro de Crookes. Esto último puede parecer solo una curiosidad anecdótica, pero se trata de otro de esos «cabos sueltos» de la ciencia. Un antiguo artilugio que, por mucho que se nos quieran hacer creer lo contrario, sirve para refutar la teoría corpuscular de los fotones. Por eso, son muchos los que han tratado de explicar su desconcertante funcionamiento, basándose en los modelos físicos vigentes, pero nadie lo ha conseguido de forma satisfactoria, hasta ahora.